Une IA qui apprend à parler comme les bébés

Proposant une approche alternative, des chercheurs de l’ETIS (CNRS/ENSEA/Cergy Paris Université) apprennent à une IA à parler en s’inspirant de la manière dont les enfants en bas âge intègrent le langage. Ce système est basé sur des boucles d’écoute d’un modèle, d’essai de prononciation et d’une écoute interne pour comprendre comment s’améliorer. Publiés dans la revue PloS Computational Biology, ces travaux permettent de s’affranchir des volumineuses bases de données utilisées dans l’apprentissage de nombreuses IA.

Qu’il s’agisse de le retranscrire ou pour communiquer avec un humain, le langage constitue un excellent terrain de jeu pour les intelligences artificielles. Beaucoup d’algorithmes tentent ainsi d’accéder au sens des mots et de mieux les manipuler. Mais plutôt que d’utiliser des algorithmes nécessitant d’énormes bases de données sonores, des chercheurs du laboratoire Équipes traitement de l’information et systèmes (ETIS, CNRS/ENSEA/CY Cergy Paris Université) ont entraîné leur IA en mimant la manière dont les bébés apprennent à parler : articuler et agencer de mieux en mieux les sons à force d’entendre d’autres personnes et soi-même.

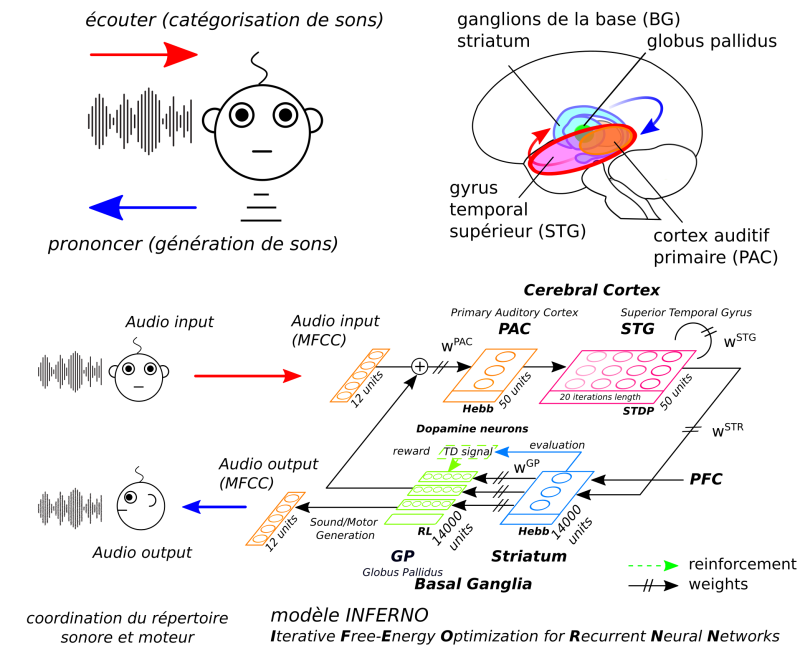

Ils se sont tout particulièrement inspirés du système cortico-basal, où les interactions entre le néocortex et les ganglions de la base du cerveau permettent de catégoriser les sons et de les prononcer. « Ces deux aires du cerveau fonctionnent en une boucle pour parler, écouter et s’entendre parler, précise Alexandre Pitti, maître de conférences à l’université de CY Cergy Paris et membre du laboratoire ETIS. Les bébés et les enfants qui n’ont pas encore accès à la parole écoutent beaucoup, puis essayent de reproduire ce qu’ils entendent par babillage et imitation. »

Structures anciennes de notre cerveau, les ganglions de la base du cerveau sont également impliqués dans l’apprentissage par renforcement des zones du néocortex, en plus d’aider à articuler en coordonnant les muscles de la bouche et des cordes vocales. Les chercheurs ont copié ce principe avec l’architecture neuronale INFERNO : iterative free-energy optimization for recurrent neural networks, pour optimisation itérative de l’énergie libre pour réseaux de neurones récurrents. « Par un procédé d’essai et d’erreur, ce petit système optimise les sons qu’il émet en s’écoutant parler en boucle », explique Alexandre Pitti.

Le terme de free-energy est important, car il est lié à une théorie selon laquelle le cerveau est un système dynamique où différentes couches travaillent ensemble pour prédire et minimiser les erreurs. Cela lui permet de parvenir à ses fins même en partant d’un son très éloigné de l’objectif. « Le système essaye de générer les effets qu’il souhaite obtenir en trouvant les causes qui les provoquent, résume le chercheur. Le but est ici de comparer les sons et les syllabes que l’on prononce avec ceux que l’on entend de la part de gens qui savent déjà parler. »

Pour l’instant, le système ne s’écoute pas physiquement. Les boucles de rétroaction utilisent des sons retranscrits numériquement, plutôt que diffusés sur haut-parleur et réintroduits par des micros. Une situation qui n’empêche pas les deux parties d’INFERNO d’affiner et de catégoriser ses tentatives d’articuler des citations de Corneille, Feydeau, Shakespeare et Quint. L’IA est partie d’une petite banque de phrases, prononcées par une personne, puis a synchronisé ses propres sons appris avec ce qu’elle a entendu de différentes personnes.

Mais pourquoi utiliser ces principes, quand d’autres méthodes fonctionnent mieux ? « Les IA actuelles ont beaucoup de mal à apprendre en continu, elles doivent être déconnectées pour s’entraîner sur des bases de données, souligne Alexandre Pitti. Ces techniques n’existent pas dans la nature, alors que notre approche est inspirée du vivant. Nous obtenons pourtant des résultats comparables, sans avoir à entrer autant d’informations, et donc avec un coût moindre, que pour une IA classique. »

Les chercheurs sont en train d’appliquer ces travaux pour améliorer les systèmes vocaux des robots. Un travail complémentaire sur l’apprentissage de la grammaire et la modélisation de l’aire de Broca a aussi été conçu. Ils s’intéressent également à l’écriture manuscrite, dont l’apprentissage a des liens avec celui de la lecture. Cela aiderait à mieux comprendre comment les enfants abordent la lecture et l’écriture, et comment ils parviennent à manipuler des symboles tels que les lettres de l’alphabet.

Référence

Alexandre Pitti, Mathias Quoy, Sofiane Boucenna, Catherine Lavandier. Brain-inspired model for early vocal learning and correspondence matching using free-energy optimization. PloS Computational Biology, 2021.