3 lauréats du concours "La preuve par l'image" 2021 dans les labos de l'INS2I

Le CNRS a lancé en 2019 un partenariat avec l’Acfas en déclinant en France le concours photo La preuve par l’image initié en 2010 au Québec. Pour cette troisième édition CNRS, les acteurs de la recherche ont été invités à proposer leur plus belle image de science. Le pari de ce concours : partir de l’image, qui interpelle et interroge, et non des mots, pour montrer la recherche. L’image, au-delà du beau, est aussi un dispositif de recherche et d’investigation qui permet aux scientifiques de déchiffrer leurs résultats, de faire avancer les connaissances et d’engager un dialogue avec le grand public. Titres, légendes et descriptifs techniques complètent cette approche et nous plongent dans le monde fascinant de la recherche scientifique. Découvrez ici les lauréats des laboratoires rattachés à l'Institut des sciences de l'information et de leurs interactions (INS2I).

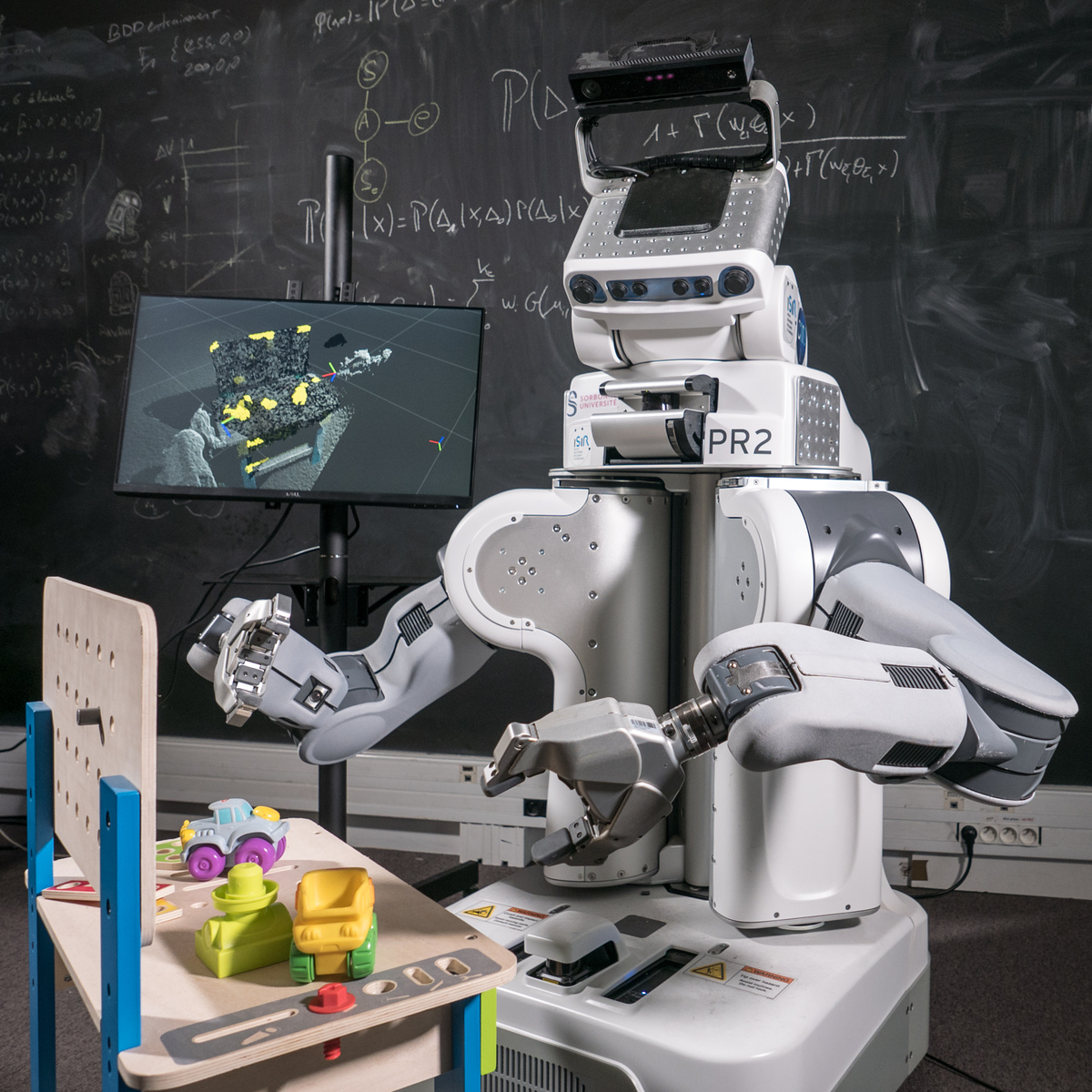

Apprendre à voir

Laboratoire impliqué :

- Institut des Systèmes Intelligents et de Robotique (ISIR - CNRS/Sorbonne Université)

Pour PR2, robot de service autonome, se repérer dans un environnement inconnu est une tâche complexe mais loin d’être impossible ! À l’aide de sa caméra 3D située sur sa "tête" et de son dispositif de capture optique de mouvement, PR2 est capable de percevoir ce qui l’entoure et apprend à voir ce qu’il peut déplacer, soulever ou enfoncer en utilisant sa pince. L’écran nous montre ici la représentation de son environnement en construction. Les petits objets avec lesquels le robot a appris qu’il pouvait interagir sont représentés en jaune. Interactions après interactions, PR2 parvient ainsi, grâce à un algorithme d’apprentissage, à construire sa propre vision du monde reposant sur ses capacités.

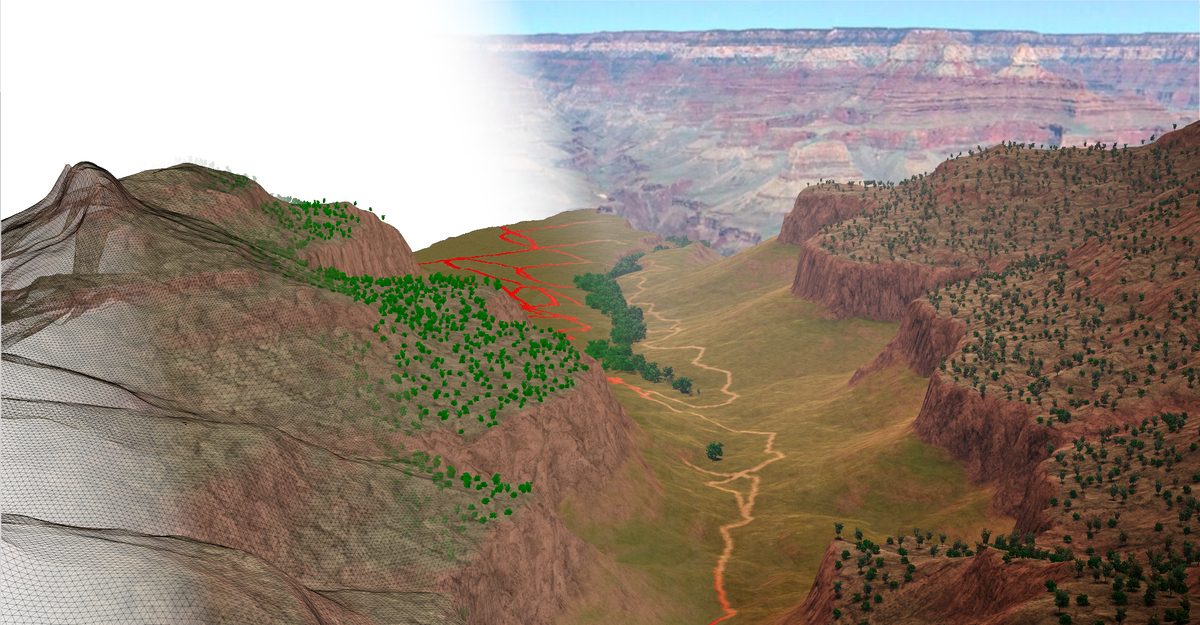

Naissance d'un canyon

Laboratoires impliqués :

- Laboratoire d’Informatique de l’École polytechnique (LIX - CNRS/Institut Polytechnique de Paris) - INS2I

- Histoire naturelle de l'Homme préhistorique (HNHP - CNRS/Museum National d'Histoire Naturelle/Université de Perpignan Via Domitia) - INEE

Ce paysage vient tout juste de naître mais il n’est pourtant pas nouveau. Il s’agit d’une modélisation numérique de l’écosystème du Bright Angel Trail, un sentier de randonnée situé dans le parc national Grand Canyon, en Arizona. À partir du terrain brut, d’informations sur l’environnement et de données biologiques, le système utilisé ici est capable de sélectionner automatiquement différentes espèces végétales et animales et de les placer à l’endroit le plus adapté afin de reconstituer un paysage. Alors que les différentes plantes sont regroupées sur les falaises ou au fond de la vallée où l’eau circule, les animaux se déplacent de ressource en ressource et forment des chemins sur les itinéraires les plus utilisés. Cet outil permet de modéliser et de contrôler des écosystèmes qui ne sont plus accessibles aujourd’hui, dans le but d’aider les paléontologues à explorer leurs sujets de recherche et valider leurs hypothèses.

Une prothèse plus intuitive

Laboratoire impliqué :

- Institut des systèmes intelligents et de robotique (ISIR - CNRS/Sorbonne Université)

Saisir un stylo, enfoncer un clou, insérer une carte de crédit, visser une ampoule… Ancien sportif paralympique de haut niveau et pilote de l’équipe française Smart ArM, Christophe Huchet s’entraîne ici pour le Cybathlon 2020. Ces Jeux Olympiques hors normes sont organisés depuis 2016, tous les 4 ans, pour les personnes en situation de handicap équipées de technologies actives et robotiques. L’athlète est équipé d’une prothèse de bras, spécialement conçue pour lui, qui est l’une des seules de la compétition à posséder un coude robotisé actif en plus d’une main et d’un poignet. Grâce à un mode de contrôle innovant, ce prototype, plus intuitif, utilise la lecture des mouvements du haut du corps de Christophe pour anticiper sa volonté et accompagner son mouvement. Au-delà des nombreux défis scientifiques, le Cybathlon vient mettre en lumière les incroyables performances de ces athlètes du quotidien.

Pour aller plus loin

- Découvrez tous les lauréats 2021 sur le site du Concours "La preuve par l'image"

- Découvrez l'exposition "La preuve par l'image 2021" de CNRS Images